Il pericolo reale delle fake news generate dall’intelligenza artificiale

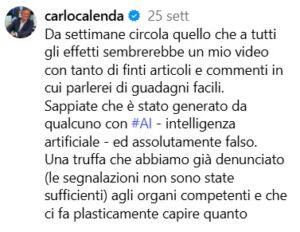

Un video circolato per mesi sui social mostra Carlo Calenda promuovere guadagni facili. Lo scenario è verosimile: l’esposizione decisa, il volto inconfondibile, persino articoli e commenti a sostegno sembrano autentici. Ma nulla di tutto ciò è vero. Lo ha denunciato lo stesso Calenda il 25 settembre: «Sappiate che è stato generato da qualcuno con AI – intelligenza artificiale – ed è assolutamente falso».

Il caso è emblematico di una nuova fase della disinformazione: quella in cui i deepfake, contenuti audio-video prodotti con l’intelligenza artificiale per simulare in modo realistico volti e voci di personaggi pubblici, diventano strumenti di truffa e manipolazione su larga scala.

Il pericolo è concreto e duplice. Da un lato, c’è il danno immediato per la persona coinvolta: la credibilità messa in discussione, il nome associato a contenuti truffaldini, la difficoltà di intervenire tempestivamente quando il contenuto è già virale. Dall’altro, c’è un rischio sistemico: la fiducia collettiva nell’informazione – già gravemente compromessa nell’era dei social – viene ulteriormente erosa. Se tutto può essere falsificato, cosa possiamo ancora considerare vero?

Il caso Calenda non è isolato

Da mesi si susseguono segnalazioni di deepfake che ritraggono politici, imprenditori, influencer o celebrità intenti a promuovere investimenti miracolosi, criptovalute fasulle, o a rilasciare dichiarazioni mai fatte. L’intelligenza artificiale generativa rende questi contenuti sempre più convincenti e facili da produrre: bastano pochi minuti di video autentico per ricostruire voce e movimenti facciali di una persona con sorprendente fedeltà.

A preoccupare è anche la lentezza della risposta istituzionale. Calenda segnala che, nonostante le denunce, «le segnalazioni non sono state sufficienti». In effetti, i meccanismi di controllo delle piattaforme social si dimostrano spesso inadeguati. E mentre si discute a livello europeo e internazionale su come regolamentare l’uso dell’IA generativa, i truffatori si muovono più velocemente.

In questo scenario, il fact-checking – fondamentale presidio dell’informazione corretta – non basta più. Occorre un salto di qualità nella regolamentazione tecnologica e una responsabilizzazione degli attori digitali, dalle big tech ai provider di IA. È necessario anche potenziare l’educazione digitale: cittadini, giornalisti, e funzionari pubblici devono saper riconoscere i segnali del falso, senza cadere nel relativismo cinico del “niente è più vero”.

Perché il volto contraffatto di Calenda è solo un avvertimento: in un’epoca in cui la verità può essere simulata, difenderla richiede nuovi strumenti e una vigilanza collettiva.